Grünere und kosteneffizientere IT mit Kubernetes.

Workloads done right.

Wie Kubernetes Ihre IT grüner gestaltet und die nachhaltige Ressourcennutzung in der Bereitstellung und Verwaltung von Anwendungen fördert.

Über die Digitalisierung wurden – zurecht – bereits viele Lobeshymnen gesungen. In Sachen Nachhaltigkeit gibt es aber durchaus noch Verbesserungspotential.

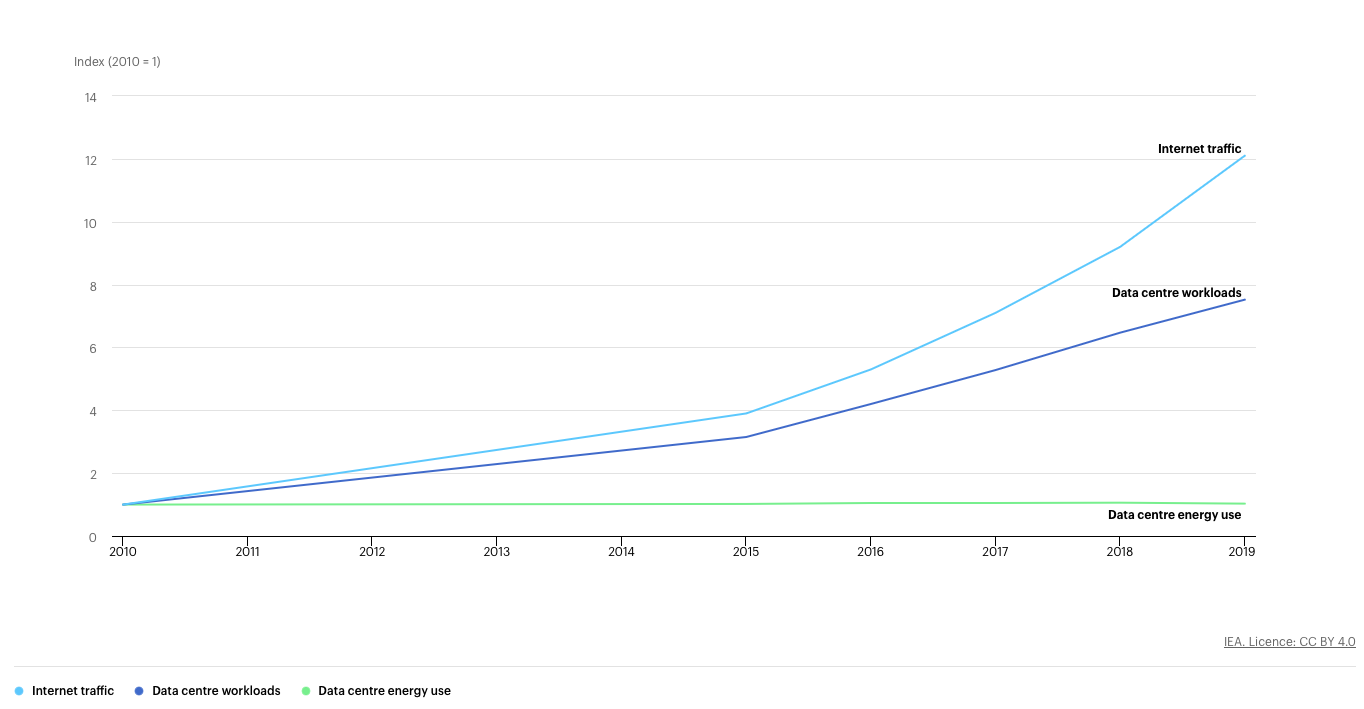

Digitalisierte Prozesse und moderne Kommunikation erhöhen Produktivität, beschleunigen Entscheidungen, helfen Rohstoffe zu sparen und ermöglichen uns täglich auf unnötige Reisen zu verzichten. Trotzdem gleichen diese Gewinne nur schwerlich die gestiegenen Umweltkosten dieser Transformation aus. [1] Digitalgeräte von Endverbrauchern, Netzwerk-Infrastrukturen und Rechenzentren verursachten 2019 etwa 4.2% der globalen Treibhausemissionen und der Anteil steigt sogar weiterhin. Rechenzentren sind für etwa 15% dieser Emissionen verantwortlich. [2]

Ökologischer Fußabdruck 1x1

Der ökologische Fußabdruck von Rechenzentren wird primär durch den Stromverbrauch genutzter Computer- und Infrastruktur-Ressourcen, durch Kühlsysteme und die Produktion der Hardware verursacht. Energieeffizientere Hardware auf z.B. der Basis von ARM-CPUs und Rechenzentren an Standorten mit günstiger Energieversorgung (siehe https://app.electricitymaps.com/map) helfen dabei, diese Bilanz zu verbessern. Möchte man den CO2-Ausstoß aber noch weiter minimieren, ist es generell auch sinnvoll, die hochoptimierte Infrastruktur großer Cloud Service Provider zu nutzen, anstatt eigene Rechenzentren zu betreiben oder gar neu aufzubauen. Aufgrund ihrer Größe sind diese Anbieter in der Lage, Workloads erheblich besser und gezielter zu verteilen. Sie betreiben daher immer nur aktiv benötigte Maschinerie anstatt unnötige Ressourcen auf Verdacht vorzuhalten. Ebenso können ihre sehr großen Kühlsysteme in der Regel effizienter betrieben werden. Da der Energieverbrauch eines Cloud Providers inherent an Betriebskosten und somit den Gewinn des Kerngeschäfts gekoppelt ist, sind Cloud Service Provider natürlich stetig bestrebt diesen zu optimieren. Daher blieb der Energieverbrauch in Rechenzentren trotz einer in etwa Verzehnfachung der Last im letzten Jahrzehnt sogar relativ konstant.

Green = Future = Efficient = Economic

Hier kann man als Entwickler von den Großen lernen: die benötigte Workload sollte immer nur auf dem schlankestmöglichen Gesamtsystem ausgeführt werden. Aktuelle und gut in Cloud-Provider integrierte Kubernetes Cluster bieten Entwicklern von Haus aus mächtige Werkzeuge, um bereits bestehende Anwendungen in Containern maximal skalierbar zu betreiben, wenn die Anwendung und der Service Provider dies architekturell unterstützen. Kubernetes wird oft auch als K8s abgekürzt.

Der Ressourcenverbrauch einzelner Deployment-Pakete, sog. Pods, kann mit dem Vertical Pod Autoscaler dynamisch abgeschätzt und automatisch verwaltet werden. Das Cluster lernt somit automatisch, wie sich der Ressourcenverbrauch eines Pods in der Praxis tatsächlich verhält und passt sein Verhalten darauf an. Ein sinnvoll konfigurierter Horizontal Pod Autoscaler kann dafür sorgen, dass Performance-relevante Pods genau so oft vorhanden sind, wie sie für die aktuelle Nachfrage benötigt werden. Im Zusammenspiel mit einem gut in den Cloud-Provider integrierten Cluster-Autoscaling wird dann auch die Anzahl der benötigten Knoten im Cluster mitskaliert. Somit entstehen für den Nutzer nur die tatsächlich benötigten Kosten und keine Ressourcen liegen brach. Auch eine Steuerung der Pod-Skalierung anhand von definierten Zeitperioden (kube-downscaler) oder proaktiv anhand erlernter Last (PredictKube) ist ganz einfach integrierbar. Tools wie KEDA ermöglichen es auch Workloads anhand der Auslastung von Queue-Services im Cloud Provider zu skalieren und vieles mehr.

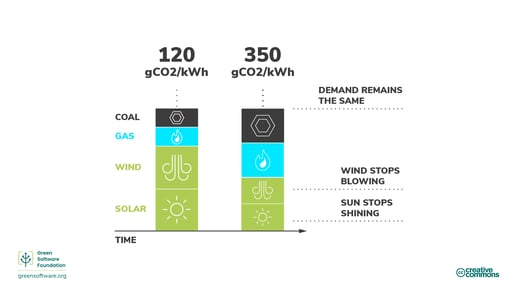

Energieverbrauch mit CO2-Ausstoß gleichzusetzen ist leider etwas zu simplistisch gedacht. Konsequentes GreenOps-Denken geht hier noch etwas weiter: die CO2-Intensität der verwendeten Elektrizität ist nämlich nicht konstant, sondern von den aktuellen Anteilen der genutzten Energiegewinnungsmethoden abhängig.

Quelle: https://learn.greensoftware.foundation/carbon-awareness/

Wenn die Applikationslast nicht in Echtzeit abgearbeitet werden muss, z.B. bei regelmäßigen Aufgaben wie Backups, aufwändigen Entwicklungspipelines oder der Daten-Prozessierung oder Analyse, wie sie auch beim Trainieren von AI-Daten geschieht, dann kann es auch durchaus eine Option sein, Workloads dann hochzuskalieren, wenn CO2-arme Energiequellen genutzt werden können. Mit einem Autoscaler wie KEDA im Zusammenspiel mit dem Kubernetes Carbon Intensity Exporter ist sogar das problemlos möglich.

In der Summe spart ein konsequentes Integrieren technischer Möglichkeiten in die eigene Workload nicht nur sehr viel Geld, sondern tut auch etwas für die Umwelt!

QUELLEN

[1] Lange, S., Pohl, J., & Santarius, T. (2020). Digitalization and energy consumption. Does ICT reduce energy demand?. Ecological economics, 176, 106760.

[2] GreenIT.fr, 2019. The environmental footprint of the digital world. Siehe https://www.greenit.fr/wp-content/uploads/2019/11/GREENIT_EENM_etude_EN_accessible.pdf

Dir gefällt dieser Beitrag....

und du möchtest mehr zum Thema Kubernetes erfahren?

Unter den folgenden Links findest du den Weg zu unserem Kubernetes Whitepaper